喜讯!ARClab团队论文被人工智能顶级会议AAAI 2026录用

2025年11月,浙江大学计算机系统结构实验室(ARClab)施熠为第一作者的论文“Enhancing Meme Emotion Understanding with Multi-Level Modality Enhancement and Dual-Stage Modal Fusion”被人工智能顶会The 40th Annual AAAI Conference on Artificial Intelligence (AAAI)录用。该论文由陈文智教授和魏成坤老师指导,提出了一种针对模因(meme)的情感理解框架,通过对原始模因信息的多层级模态增强以及细粒度的双阶段模态融合策略,更加准确地捕捉了模因背后的情感倾向,为多模态情感分析提供了一种有效的实现方案。

会议介绍

AAAI是人工智能领域的国际顶级会议之一,也是中国计算机学会(CCF)认定的A类会议。会议汇聚全球AI领域最前沿的研究成果,涵盖机器学习、自然语言处理、计算机视觉、多智能体系统等方向,是全球科研人员展示创新工作、交流前沿思想的重要平台。

论文介绍

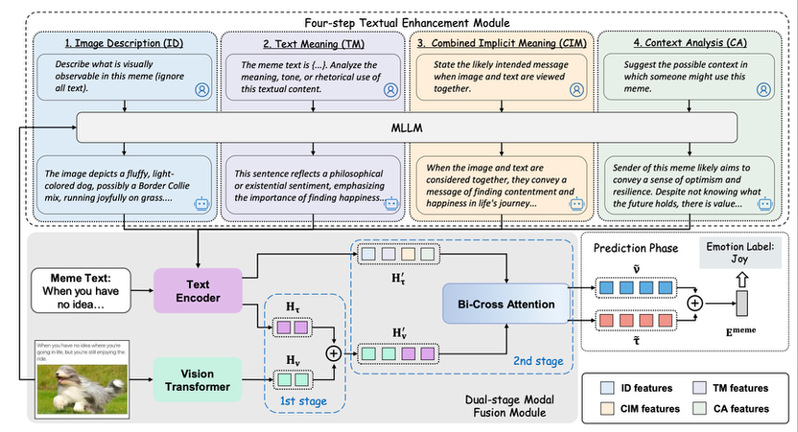

随着互联网文化的发展,人们越来越倾向于使用“模因”(Meme)来表达自己的情感倾向,模因情感理解(MEU)也成为一个重要的课题。然而,当前的MEU方法存在两大缺陷:一是缺乏细粒度的模态融合策略,而是对模因的隐含含义以及背景知识挖掘不足。为了解决这些挑战,本文提出了一个新颖的MEU框架MemoDetector。首先,我们利用多模态大模型对模因进行四步骤文本增强,充分挖掘模因背后的隐含含义以及背景知识,这些多层次的由浅入深的增强信息,为后续基于小模型的分类提供了有效指引。之后,我们设计了一个新颖的双阶段模态融合策略,第一阶段对原始模因图像和文本进行浅层融合,而第二阶段深度整合增强的视觉和文本特征,这种层次融合使模型能更好地捕捉细微的跨模态情感线索。

在多数据集上的实验结果表明,我们的方法始终优于基线。具体来说,MemoDetector在MET-MEME上提高了4.3%的F1分数,在MOOD上提高了3.4%。进一步的消融研究和深入分析验证了我们的方法的有效性和鲁棒性,突显了其在推进MEU方面的强大潜力。

作者介绍

论文第一作者施熠,为浙江大学计算机系统结构实验室(ARClab)2024级在读硕士生,主要研究方向为多模态内容理解和大模型安全。