喜讯!陈文智教授团队论文被国际顶级期刊TDSC录用

浙江大学计算机系统结构实验室博士生虞楚尔的论文“Diff-ID: An Explainable Identity Difference Quantification Framework for DeepFake Detection”于2024年2月被网络安全领域的顶级期刊IEEE Transactions on Dependable and Secure Computing录用。该论文由陈文智教授指导,分析了Deepfake换脸伪造图像内在的身份特征缺失,提出基于真实参考人脸计算伪造人脸的身份信息损失的检测方法。该方法对不同换脸方法生成的伪造图片具有良好的检测泛化性,同时对于图像压缩有很强的鲁棒性。

期刊介绍

IEEE TDSC是一本双月刊,是由IEEE Computer Society出版的权威期刊之一。该期刊致力于研究计算机系统和网络的可靠性、安全性、以及相关领域的前沿技术,目标是促进对可信赖和安全计算的研究,以应对现代计算环境中日益增长的威胁和挑战。

Deepfake检测与挑战

随着深度生成模型的进步,深度伪造技术Deepfake被提出并快速发展。Deepfake通常涉及将某人的脸部替换到其他人的图片或影片中,以产生虚假的场景或言论,可能被滥用于制造虚假信息、诈骗、人格诽谤等活动,会对个人、社会和政治造成严重的负面影响。因此,近年来研究者致力于开发检测方法和对抗技术。然而,检测Deepfake变得越来越困难,因为(1)在先进的伪造操作中没有留下明显的痕迹;(2)不同操作中的伪造痕迹非常不同,很难将模型在特定数据集上训练的结果推广到其他未见过的Deepfake方法;(3)伪造痕迹可以很容易地被图像失真(例如压缩)所破坏。令人担忧的是,现有的Deepfake检测方法在泛化或鲁棒性方面存在局限性。

基于身份信息差异量化的可解释鲁棒检测方法

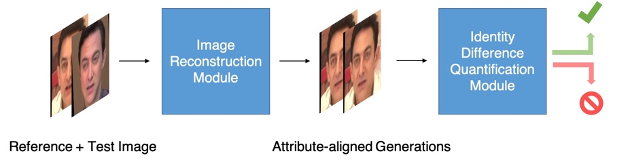

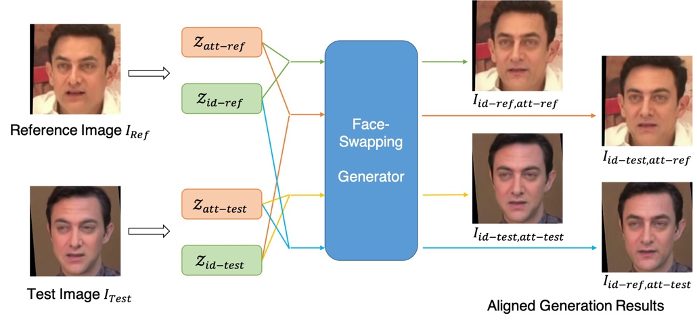

我们观察到,虚假图像的身份不可避免地与真实身份存在差异。在Deepfake换脸过程中,目标图像的身份被源图像的身份替换,而目标脸部的属性,包括头部姿势、表情、光线、遮挡、发型和其他背景内容被保留。由于身份特征与属性特征难以完全解耦,源的身份特征与目标的属性特征之间存在固有冲突,伪造图像通常会出现身份丢失的情况。因此,我们提出方法Diff-ID,将待测图像的属性特征对齐到参考图像(与测试图像有相同身份的真实图像)相同的属性空间上,以削弱属性特征对身份特征的干扰,再进行待测图像与参考图像身份特征差异的量化,以检测伪造图像。

在属性特征对齐阶段,Diff-ID分别提取参考图像和测试图像的身份特征,属性特征,两两组合输入到换脸生成器中生成进行了属性特征对齐的重建图像。该重建图像显示了在参考图像/测试图像的属性空间上表达参考图像/测试图像身份特征的结果。

通过构建重建结果中的数学关系,我们构造了一个身份特征差异的量化指标,并以此作为区分真实图像和伪造图像的分类依据。Diff-ID无需在Deepfake相关的伪造数据上进行训练,在多个换脸数据集上(FaceForensics++、Google DeepFake Detection、CelebDF、DeeperForensics-1.0)均取得了超过90%的AUC,相比之前的工作大幅提高了检测准确率。同时,Diff-ID利用身份特征这种高级语意信息作为伪造检测的线索,对图像压缩也表现出极高的鲁棒性。

作者介绍

论文第一作者虞楚尔为浙江大学计算机系统结构实验室(ZJU ARClab)在读博士生,主要研究方向为人工智能安全、数字图像取证等。